‘Killer Robots’, ‘Lethal Autonomous Robotics’, ‘Terminator-style robots’ – het zijn enkele termen die verbonden worden aan de autonome wapensystemen van de toekomst. Dit roept angstaanjagende beelden op, maar is deze angst terecht? Nieuwe wapensystemen, methodes en middelen van oorlogsvoering hebben door de eeuwen heen tot revolutionaire veranderingen gezorgd. Vaak veroorzaakten deze ontwikkelingen heftige discussies over de juridische toelaatbaarheid en ethische aanvaardbaarheid van deze wapens en methoden. Vooral wapens welke de afstand tussen strijdende partijen vergroten, worden al van oudsher als problematisch ervaren. De kruisboog en het buskruit werden destijds gezien als oneerlijke wapens die enkel gebruikt werden door lafaards.[1] Vergelijkbare discussies zien we bij huidige wapensystemen, zoals ‘Remotely Piloted Aircrafts’ (RPAs) en autonome wapens (AWs). Dat deze discussies moeizaam verlopen blijkt uit eerdere bijdragen in dit blad.[2] Eén van de grote problemen in het huidige debat over deze (hyper)moderne en wellicht futuristische systemen, is dat emotie vaak de overhand heeft en zo feiten vertroebelt. Een RPA is niet autonoom en een AW is geen killer robot. De vraag die blijft: wat zijn het dan wel?

M. Ekelhof, LLM*

Liesbeth Kruizinga concludeerde hier eerder dat op afstand bestuurbare (lees: onbemande) en autonome systemen in het actuele discours regelmatig verwisseld worden. De discussie in onderzochte Britse, Duitse en Nederlandse media toont dat deze verwarring het debat vertroebelt en emotie de overhand krijgt. Kruizinga legt terecht uit over onbemande systemen: ‘MALE UAVs hebben automatische systemen om bijvoorbeeld zelfstandig te landen, maar opereren niet autonoom. Een MALE UAV is dan ook geen autonome robot die zelfstandig beslissingen [neemt].’[3]

Wellicht een open deur, maar zeker geen onbelangrijke conclusie. Want wat is ‘autonomie’ nu daadwerkelijk en waarom veroorzaakt het idee van autonome wapens een onbehaaglijk gevoel? Vrijwel direct brengt men autonome systemen in verband met Hollywood films zoals The Terminator en i-Robot; gewelddadige films waarin de robots zich vaak tegen hun schepper keren om vervolgens de wereld over te nemen. Dit is duidelijk geen realistisch beeld, maar wat zijn autonome wapens dan wel? Hoog tijd om een aantal zaken uit elkaar te halen en helderheid te scheppen.

Die helderheid neemt onder meer toe doordat defensiemedewerkers steeds vaker deelnemen aan politieke discussies en maatschappelijke debatten over dit soort onderwerpen. Dit draagt bij aan een genuanceerder debat waarmee misverstanden, speculaties en onrust over de ontwikkeling van (onder andere) autonome wapens beperkt kunnen worden. Waar de discussie nu veelal gaat over de onbemande MQ-9 Reaper, zullen ook autonome wapens langzaam in beeld komen. Enkele NGOs,[4] waaronder de Nederlandse Pax (voorheen IKV Pax Christi), stelden al kritische vragen over de Nederlandse positie inzake autonome wapensystemen of, zoals zij ze noemen, ‘killer robots’.

Het Amerikaanse X-47B ‘ Unmanned Combat Air System’ (UCAS) kan autonoom diverse taken uitvoeren, zoals bijtanken tijdens de vlucht, ontwijkende manoeuvres uitvoeren, een target identificeren en opstijgen en landen van een vliegdekschip. Foto US Navy, T. Walter

Er is geen internationaal geaccepteerde definitie voor autonome wapensystemen. Dit maakt duidelijke communicatie over deze systemen lastig. Ondanks het ontbreken van een standaarddefinitie worden AWs in de meeste gevallen omschreven als offensieve wapensystemen welke, na activering, zonder menselijke controle doelwitten kunnen selecteren en uitschakelen (targeting). Deze omschrijving impliceert dat een autonoom wapen, na activering, volledig zelfstandig zal handelen. Dit lijkt zeer onwaarschijnlijk en erg onwenselijk. Vandaar dat gekeken wordt naar een alternatief concept waarbij de menselijke controle de hoofdrol speelt. Dit wordt het concept van ‘Meaningful Human Control’ genoemd.

Doel artikel

Van 13 tot 16 mei 2014 en van 12 tot 17 april 2015 bespraken delegaties uit 87 landen vragen die voortvloeien uit de ontwikkeling in technologieën betreffende ‘Lethal Autonomous Weapons Systems’ tijdens de expert meetings van het ‘Verdrag inzake het verbod of de beperking van het gebruik van bepaalde conventionele wapens die geacht kunnen worden buitensporig leed te veroorzaken of een niet-onderscheidende werking te hebben’ (hierna: CCW) in Genève.[5] Ook Nederland is Verdragspartij. Het is daarom belangrijk dat Defensie en Buitenlandse Zaken deze vraagstukken van autonome systemen adresseren en analyseren om het internationale debat te kunnen volgen én mede te bepalen. Vooral ook om de praktische kant van deze ontwikkeling te kunnen overzien en een standpunt te bepalen.

Minister van Defensie Hennis-Plasschaert gaf in november 2013 aan dat ‘Defensie [..] niet [werkt] aan LARs [Lethal Autonomous Robotics] en [..] daar ook geen plannen voor [heeft].’[6] Desondanks heeft de discussie over deze autonome systemen wel de Nederlandse politiek bereikt. Ook voor Nederland en Defensie zijn AWs een actueel vraagstuk, al is het maar omdat ‘anderen’ ze wel ontwikkelen. Doel van dit artikel is dan ook om een effectieve bijdrage te leveren aan het publieke debat en licht te schijnen op de ontwikkeling van wapensystemen met autonome functies.

Opzet artikel

Ik zal mij richten op de AWs of wapensystemen met autonome functies. Daarbij concentreer ik mij allereerst op het publieke debat en het gebruik van verschillende definities. Ik sta vervolgens stil bij het verschil tussen automatische en autonome systemen. Verschillende mensen gebruiken de woorden autonoom en automatisch op verschillende manieren. Dit maakt communicatie over autonomie in wapensystemen uitermate lastig. Aansluitend verschaf ik inzicht in enkele ontwikkelingen op het gebied van autonome technologieën, waarbij het onderscheid tussen acceptabele en cruciale functies met een (hoge) mate van autonomie centraal staat. Dit onderscheid is van belang wanneer deze geplaatst wordt binnen de context van targeting. Deze functies maken onderdeel uit het doelbestrijdingsproces (targeting proces). Ik behandel dit proces in relatie tot cruciale functies met autonomie om aan te geven dat een toename in autonomie niet gelijk staat aan een afname van menselijke controle. Vervolgens zal ik mij concentreren op de menselijke controle in dit doelbestrijdingsproces en de ontwikkeling van een nieuw concept: Meaningful Human Control. Eerst richt ik mijn aandacht op de afname van menselijke controle in huidige (wapen)systemen. Ik leg vervolgens uit hoe het oorlogsrecht dit fenomeen hanteert of negeert. Door huidige systemen met een mate van autonomie in cruciale functies in de operationele context te plaatsen en te focussen op het doelbestrijdingsproces leg ik uit hoe menselijke controle aanwezig blijft. Deze vormen waarin die menselijke controle aanwezig blijft – soms anders en minder herkenbaar dan voorheen – leggen de basis voor de ontwikkeling van het concept van Meaningful Human Control.

Het publieke debat

In november 2012 publiceerde het Amerikaanse ministerie van Defensie een rapport waarin zij een autonoom wapensysteem omschrijven als een ‘weapon system that, once activated, can select and engage targets without further intervention by a human operator.’[7] Dit beleidsstuk veroorzaakte veel reuring, voornamelijk binnen de ontwapeningsgemeenschap. In reactie op dit beleidsstuk en de ontwikkelingen op technologisch gebied startte in april 2013 een internationale coalitie, bestaande uit NGOs zoals Human Rights Watch en Pax, de ‘Campagne tegen Killer Robots’ .[8] Deze campagne roept op tot een preventief verbod op de ontwikkeling, de productie en het gebruik van volledig autonome wapensystemen. Al snel landde de discussie over deze toekomstige wapensystemen in internationale politieke fora zoals de Mensenrechtenraad van de Verenigde Naties in mei 2013[9] en de CCW in november 2013.[10]

Volledig autonome wapens staan nu op de politieke agenda, maar hun daadwerkelijke bestaan hangt nog van vele factoren af. Mogelijk worden deze wapensystemen zelfs nooit ontwikkeld. Overigens zijn politieke discussies over de ontwikkeling van bepaalde wapens voordat ze bestaan zeldzaam, maar niet nieuw. In 1998 verklaarde de CCW Protocol IV van kracht dat een preventief verbod oplegt op het gebruik en de transfer van permanent verblindende laserwapens.[11] Ten tijde van het verbod waren zulke wapens nog niet ontwikkeld, desondanks verklaarden staten dat permanent verblindende laserwapens verboden moesten worden omdat zij buitensporig leed zouden veroorzaken en daarmee strijdig zouden zijn met het oorlogsrecht.

Diverse niet-gouvernementele organisaties, waaronder Human Rights Watch, Pax en de Campaign to stop Killer Robots, voeren inmiddels campagne tegen autonome wapens. Foto Campaign to stop killer robots

Preventieve wapenverboden zijn schaars, maar gezien de snelle technologische ontwikkelingen op het gebied van autonomie ontstaat de vraag of preventieve verboden, of misschien een (tijdelijke) opschorting van de ontwikkeling van complexe autonome wapensystemen geboden is. Zoals voormalig minister van Buitenlandse Zaken Timmermans al opmerkte in een interview met NRC Handelsblad in 2012, is het in de militaire geschiedenis meestal zo dat de regelgeving pas tot stand komt wanneer systemen al operationeel zijn. ‘Eerst komen er nieuwe wapensystemen, en die worden dan ingezet, en vervolgens gaat men denken: binnen welke regelgeving vindt die inzet plaats en klopt dat wel?’[12] Dit kan tot discussie leiden, zoals we nu zien bij de inzet van bewapende drones of, zoals de krijgsmacht deze systemen noemt, RPAs.[13] Daartegenover staat dat het bijzonder weinig zin heeft om te zeggen: er is een nieuw wapensysteem, oei, dat vinden we eng, dat moet maar weg, aldus Timmermans.[14] Hij concludeert terecht dat, ervan uitgaande dat sommige wapensystemen er simpelweg gaan komen, de vraag moet worden gesteld onder welke condities en voorwaarden de inzet van zulke wapensystemen gelegitimeerd is.[15] Dat is bij autonome wapensystemen niet anders.

Automatisch of autonoom?

Automatische of autonome functies in wapensystemen is niet nieuw. Al in de jaren zestig werd het Patriot-luchtverdedigingssysteem ontworpen. En al sinds de jaren 70 maakt de Nederlandse marine gebruik van de Goalkeeper, een nabijheidsverdedigingssysteem met een volautomatische modus vanwege de vaak hoge dreigingen en korte reactietijd. Beide systemen kunnen zonder menselijke inbreng opereren; dit geldt voor zowel het volgen van doelen, het onderscheiden van vriend en vijand alsook het berekenen en leiden van onderschepping.[16] De rol van de mens is dan niet anders dan die van een operator en supervisor bij vele andere computersystemen.[17] Deze systemen worden regelmatig aangeduid als automatische systemen en niet als autonome systemen.

Autonome of automatische functies in wapensystemen zijn niet nieuw; ze worden al tientallen jaren toegepast, onder meer bij het Patriot-luchtverdedigingssysteem. Foto MCD, R. van Eerden

De grens tussen automatische en autonome systemen is echter dun en moeilijk te trekken. Volgens sommigen zit het verschil in de omgeving waarbinnen het systeem opereert.[18] Meer specifiek, een automatisch systeem zou in een gesloten en gestructureerde omgeving opereren waardoor het systeem niet hoeft te reageren op onverwachte omstandigheden, vooral in een defensieve context. Een autonoom systeem zou daarentegen opereren in een dynamische en open omgeving waarbinnen het systeem moet kunnen anticiperen op onverwachte veranderingen in de omgeving, vooral in een offensieve context.[19] Volgens het Britse ministerie van Defensie is het verschil tussen automatisch en autonoom te vinden in de voorspelbaarheid van een systeem. ‘[A]n automated or automatic system is one that, in response to inputs from one or more sensors, is programmed to logically follow a pre-defined set of rules in order to provide an outcome.’[20] Terwijl een autonoom systeem beschreven wordt als een system dat ‘able [is] to take appropriate action to bring about a desired state. It is capable of deciding a course of action, from a number of alternatives, without depending on human oversight and control.’[21]

De termen automatisch en autonoom worden vaak toegepast in verschillende kennisdisciplines waardoor ze verschillende betekenissen hebben. Verwarrend genoeg worden ze bovendien regelmatig door elkaar gebruikt om dezelfde systemen te beschrijven. Dit blijft niet beperkt tot de termen automatisch en autonoom; vergelijkbare discussies gaan over kunstmatige intelligentie en terminologie als human on-the-loop en out-the-loop.[22] Het resultaat is vertroebeling over de definitie en omschrijving van de systemen in kwestie met als effect dat niemand precies lijkt te weten wat een autonoom wapensysteem is en waartoe zij in staat zijn. Het bepalen van een specifieke en alomvattende definitie van autonome wapens lijkt in dit stadium van de discussie onmogelijk. Toch is inzage in relevante concepten en begrippen onontbeerlijk om feiten en fabels te kunnen scheiden. In plaats van de aandacht te vestigen op verwarrende labels als automatisch en autonoom, stel ik een andere benadering voor waarbij ik mij primair concentreer op de inzet van (autonome) wapensystemen voor targeting doeleinden. Voor het vervolg van dit artikel zal ik verwijzen naar autonome wapensystemen (AWs) als wapensystemen met autonomie in cruciale functies binnen het targeting proces.

Cruciale functies

Een factor die verwarring veroorzaakt in de definitiediscussie is de gedachte dat AWs zich op een bepaald punt op een autonomiespectrum bevinden. Terminologie zoals supervised autonomie, scripted autonomie, partial autonomie, semi- en volledige autonomie bevestigen dit.[23] Het spectrum van autonomie heeft een laagste deel – op afstand bestuurbare systemen (zoals de MQ-9 Reaper) waarbij de mens de volledige controle heeft – en het heeft een hoogste deel waar de mens geen controle meer zou hebben over systemen: volledig autonome systemen. Enkele staten hebben interesse getoond in de ontwikkeling van systemen die tot de hogere delen van dit spectrum behoren.[24] Zodra men beweegt op dit spectrum en andere niveaus van autonomie van toepassing zijn, ontstaat onduidelijkheid over waar een systeem geplaatst zou moeten worden en verliest het spectrum zijn waarde in het aanpakken van deze problematiek. De Defense Science Board, een adviesorgaan van het Amerikaanse ministerie van Defensie, legt uit dat het gebruik van niveaus van autonomie contraproductief is omdat het de nadruk legt op het systeem in plaats van de samenwerking tussen mens en systeem. Bovenal concludeert de Board dat het spectrum ten onrechte suggereert dat een systeem zodanig kan worden ontworpen dat het gedurende een hele missie op een specifiek en gelijkblijvend niveau van autonomie opereert.[25] Zoals Kruizinga al eerder schreef, kunnen systemen verschillende autonome functies hebben zoals opstijgen en landen. Van het uitvoeren van een volledige missie op een bepaald vast niveau van autonomie is dus in de meeste gevallen geen sprake. De aanwezigheid van autonome functies bepaalt de mate en complexiteit van autonomie van het systeem en het onderscheid tussen deze functies ondersteunt het begrip van AWs.

Nederland zal naar verwachting vier MQ- 9 Reaper-toestellen aanschaffen. De Reaper is een op afstand bestuurbaar vliegtuig waarbij de menselijke operator volledige controle heeft. Op de foto landt een Amerikaans toestel op Joint Base Balad, in Irak. Foto USAF, E. Gudmundson

Neem bijvoorbeeld de MQ-9 Reaper, waarvan Nederland er naar verwachting vier zal aanschaffen. Dit is een op afstand bestuurbaar vliegtuig waarbij de menselijke operator volledige controle heeft over het handelen van de RPA. Desondanks bestaat er software die bepaalde functies kan ‘autonomiseren’. Deze functies blijven meestal beperkt tot navigatie, taxiën, opstijgen en landen van RPAs zoals de Global Hawk en Sky Warrior.[26] Maar dit is tegenwoordig al lang niet meer de nieuwste en meest geavanceerde technologie. Hiervoor moeten we kijken naar recentere ontwikkelingen zoals de Britse en Amerikaanse Unmanned Combat Aerial Vehicles (UCAV) Taranis en X-47B.

BigDog is een soort robot-muildier, heeft vier poten en is speciaal ontwikkeld voor ruw terrein. Autonomie in functies als navigatie en transport is algemeen geaccepteerd. Het ‘muildier’ kan 200 kilo vervoeren. Foto US Marine Corps, M. Walters

Sinds 2000 ontwikkelt het Amerikaanse bedrijf Northrop Grumman de X-47B.[27] De X-47B verkeert nog in de testfase, maar is al succesvol gebleken in het autonoom bijtanken tijdens de vlucht, autonoom uitvoeren van ontwijkende manoeuvres, autonoom identificeren van een target en het autonoom opstijgen en landen van een vliegdekschip (een van de meest complexe manoeuvres binnen de luchtvaart en daarmee een uitzonderlijke prestatie).[28] De technologie die dit mogelijk maakt is een stuk complexer dan de technologie voor het opstijgen en landen van RPAs als de Global Hawk en de Sky Warrior. De vraag is wat het effect is van autonomie in verschillende functies bij de inzet van AWs voor targeting doeleinden. Hierom dient onderscheid te worden gemaakt tussen acceptabele en cruciale functies.

Volgens UNIDIR, United Nations Institute for Disarmament Research, is autonomie in functies zoals navigatie en transport (bijvoorbeeld muildier BigDog)[29] algemeen geaccepteerd, maar is autonomie in functies zoals doelselectie juist onderwerp van discussie.[30] Het Internationaal Comité van het Rode Kruis voegt hieraan nog andere functies toe, namelijk: het zoeken, volgen, selecteren en aanvallen van doelwitten.[31] Deze functies spelen een grote (cruciale) rol bij doelbestrijding en zijn daarom vaker onderwerp van discussie. Autonomie in cruciale functies kan separaat beoordeeld worden, maar al deze functies maken onderdeel uit van een breder proces: het targeting proces (doelbestrijdingsproces).Kortom, het aangrijpen van doelen en daarbij het daadwerkelijke geweldgebruik wekken diepgaande zorgen op. Het zoeken, volgen, selecteren en aanvallen van doelwitten vormen essentiële elementen in de uitvoering van het targeting proces. Om te kunnen spreken van Meaningful Human Control bij de inzet van wapensystemen met autonomie in deze cruciale functies moet er gekeken worden naar de menselijke rol in het targeting proces.[32]

Het targeting proces

Het targeting proces is een leidend proces in de uitvoering van operaties in moderne oorlogsvoering. Targeting of doelbestrijding is een veelgebruikte uitdrukking in de context van militaire operaties. Het is al lang niet meer een term die enkel door militairen wordt gebruikt. Steeds vaker is targeting ook onderwerp van politieke en maatschappelijke discussies. Dit leidt tot een veelzijdigheid aan interpretaties. Regelmatig wordt verondersteld dat met targeting slechts een daadwerkelijk kinetische aanval wordt bedoeld.[33] Dat is echter een (te) beperkte uitleg. Targeting wordt ook gebruikt voor deelactiviteiten binnen het targeting proces én voor het targeting proces in zijn geheel.[34] Dit veroorzaakt verwarring, voornamelijk bij leken op dit terrein.

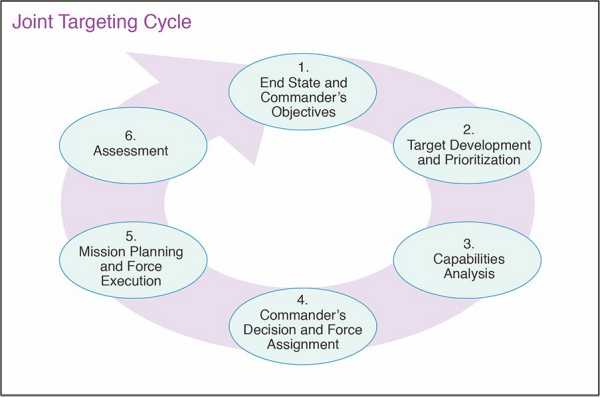

De NAVO omschrijft het targeting proces als volgt: “Joint targeting is the process of determining the effects necessary to achieve the commander’s objectives, identifying the actions necessary to create the desired effects based on means available, selecting and prioritizing targets, and the synchronization of fires with other military capabilities and then assessing their cumulative effectiveness and taking remedial action if necessary.”[35] De NAVO brengt deze cyclus illustratief in beeld met zes stappen, beginnend met het vaststellen van het oogmerk van de commandant en eindigend met een evaluatie om vooruitgang van de missie te meten en vervolgstappen te identificeren. Deze stappen zijn ruwweg onder te verdelen in drie fasen: (1) planning, (2) uitvoering en (3) evaluatie.[36] Kortom, het is van belang dat targeting niet wordt gezien als een losstaande activiteit of functie maar als een geheel aan (deel)activiteiten en functies welke binnen een nauwkeurig gepland en gecontroleerd proces wordt uitgevoerd.

Afnemende menselijke controle

Het targeting proces is traditioneel een proces geweest dat werd gepland en uitgevoerd door mensen met behulp van machines. De steeds snellere technologische ontwikkelingen lijken daar echter verandering in te brengen. Zo wordt informatie al deels op kleine schaal vergaard en verwerkt door middel van software.[37] De hoeveelheid beeldmateriaal geproduceerd door Amerikaanse RPAs in 2008 zou een enkele persoon 24 jaar kosten om te bekijken ervan uitgaande dat deze persoon niet slaapt of met de ogen knippert.[38] Tot dusver wordt informatieverwerking en beoordeling van RPA sensoren uitgevoerd door mensen. Maar de behoefte aan software ondersteuning is groot en de opkomst van (militaire) technologieën die in deze behoefte voorzien is te verwachten.[39] Generaal Norton A. Schwartz, voormalig stafchef van de Amerikaanse luchtmacht, stelt dan ook: ‘ If automation can provide a cue for our people that would make better use of their time that would help us significantly.’ [40]

Het filteren van data en informatie met softwaretoepassingen zal grotere vormen aan gaan nemen.[41] Deze door technologie geselecteerde informatie zal vervolgens bijdragen aan de selectie van het doelwit en het nauwkeurig bepalen van een locatie. Deze technologische ontwikkeling betekent echter nog niet dat het wapensysteem autonome doelselectie uitvoert. Mensen worden niet verwijderd van het besluitvormingsproces, maar de technologie zal ervoor zorgen dat de data gefilterd wordt zodat mensen enkel interpreteren wat het belangrijkste is.[42] Kortom, software is in het targeting proces een hulpmiddel, geen doel op zich.

De ontwikkeling van de technologie maakt het ook mogelijk dat (wapen)systemen steeds meer (of andere) verantwoordelijkheden krijgen, bijvoorbeeld op het gebied van doelselectie en het daadwerkelijke uitschakelen van deze doelen. Neem bijvoorbeeld de Harpy. De Harpy is een zogenaamd autonoom fire-and-forget wapen dat ook wel een zelfmoorddrone wordt genoemd.[43] De Harpy is ontwikkeld om vijandelijke radardoelen te detecteren en uit te schakelen, in principe zonder menselijke interventie. De exacte missie van de Harpy wordt vooraf gepland en geprogrammeerd in een grondstation, waarna de Harpy wordt gelanceerd vanaf een voertuig. Na de lancering vliegt deze UAV zonder verdere menselijke controle naar het aangewezen zoekgebied waarbinnen hij zoekt naar vijandelijke radarsignalen. Wanneer een verdacht signaal wordt waargenomen vergelijkt de Harpy deze zelfstandig in zijn interne bibliotheek en bepaalt of deze vriendelijk of vijandelijk is. Ook het besluit om het geselecteerde doelwit uit te schakelen vindt plaats zonder tussenkomst van de mens.[44] De Harpy zou dus te kwalificeren zijn als een systeem dat zelfstandig navigeert, een doelwit opspoort, selecteert en uitschakelt. Enkele van deze functies bestempelt het Internationaal Comité van het Rode Kruis als cruciale functies waarover menselijke controle zou moeten worden uitgeoefend. De Harpy is een voorbeeld van een bestaand systeem waarbij deze menselijke controle over cruciale functies een grijs gebied is geworden. Er is echter nooit bezwaar gemaakt tegen (de mate van autonomie bij) de inzet van de Harpy.[45] Een eventuele verklaring hiervoor behandel ik in de paragraaf over Meaningful Human Control.

Menselijke controle en het internationale recht

Doorgaans wordt verwacht dat er menselijke controle over de inzet van wapensystemen en het beoogde effect wordt uitgeoefend. Dit is impliciet terug te vinden in het humanitair oorlogsrecht (hierna: HOR). Dit is onder andere zichtbaar in de interpretatie van het proportionaliteitsbeginsel. Het proportionaliteitsbeginsel stelt dat een commandant zich ervan dient te verzekeren dat bij een aanval de te verwachten nevenschade in de vorm van burgerslachtoffers en schade aan burgerobjecten niet disproportioneel (‘excessief’) is ten opzichte van het verwachte militaire voordeel van de aanval.[46] Deze proportionaliteitstoets of ‘collateral damage assessment’ (hierna: CDA) is een van de moeilijkste en meest contextuele analyses binnen het HOR.[47] Een CDA vereist een analyse en oordeelsvermogen die uniek lijken te zijn voor het menselijk brein, namelijk ‘human judgment’.[48] Volgens het Joegoslavië-tribunaal moet voor een proportionaliteitsbeoordeling bekeken worden of een ‘reasonably well-informed person (…) making reasonable use of the information available to him or her, could have expected excessive civilian casualties to result from the attack.’ [49] Het Internationaal Comité van het Rode Kruis voegt daaraan toe dat de interpretatie van het proportionaliteitsbeginsel een zaak is van zowel ‘common sense’ als ‘good faith’ .[50]

Het lijkt erop dat het HOR er vanuit gaat dat de mens altijd een rol speelt in de toepassing van geweld. Dit betekent niet dat HOR menselijke controle verplicht of autonome functies in wapensystemen verbiedt. Over de oorlogsrechtelijke vereisten voor het gebruik van autonome wapens lopen de meningen uiteen. Sommigen zijn van mening dat het bestaande juridische raamwerk voldoende is om ook deze nieuwe ontwikkelingen op militair gebied te kunnen reguleren.[51] Bestaande beginselen en reguleringen zoals het proportionaliteitsbeginsel, het beginsel van militaire noodzaak, het beginsel van onderscheid tussen burger en militair en de verplichting tot het nemen van voorzorgsmaatregelen zijn bijvoorbeeld allen beginselen of verplichtingen die onverminderd van toepassing zullen zijn op wapensystemen met autonome functies.[52]

Anderen stellen dat er nieuwe wetgeving of beleid ontwikkeld moet worden die specifiek van toepassing is op autonome wapensystemen.[53] Een eventuele juridische verplichting zal volgens hen moeten garanderen dat er altijd betekenisvolle menselijke controle (Meaningful Human Control of MHC) bestaat over dergelijke wapensystemen die ingezet worden voor targeting doeleinden. Dit concept ‘MHC’ krijgt de nodige aandacht vanuit verschillende hoeken, zowel vanuit staten alsook belangengroepen. In mei 2014 concludeerde de CCW dat het concept van MHC geschikt zou kunnen zijn om de problematiek van AWs te adresseren.[54] Het Internationaal Comité van het Rode Kruis voegde daaraan toe dat de vele onduidelijkheden een teken zijn dat verder onderzoek naar het concept van MHC nodig is.[55] In januari 2015 omschreef het Future of Life-instituut het MHC concept als een ‘research priority’ in een open brief die is ondertekend door verschillende experts op het gebied van kunstmatige intelligentie, zoals Stephen Hawking en Tesla-CEO Elon Musk.[56]

Tot dusver is weinig onderzocht en geschreven over het concept van betekenisvolle menselijke controle of MHC. Het is dan ook allerminst duidelijk wat dit concept moet omschrijven, beperken of reguleren. Er bestaat wel een zekere overeenstemming dat de bestaande wapensystemen allen onder betekenisvolle menselijke controle staan. Het concept van MHC zou dan ook een nieuw concept zijn met het oog op de toekomst. Dat betekent dat voornoemde wapensystemen zoals de MQ-9 Reaper en de Harpy voldoen aan de eisen van MHC. Voor de MQ-9 Reaper zou dat geen verrassing moeten zijn; het betreft hier een remotely piloted aircraft en geen systeem met autonomie in de cruciale functies zoals doelselectie. De Harpy daarentegen is een systeem met autonomie in de cruciale functies zoals zoeken, selecteren en aanvallen van doelwitten. Toch is de Harpy geen AW. Maar hoe kan dat dan?

Meaningful Human Control

Zogenaamde cruciale functies zijn onderdeel van het targeting proces. Binnen dit proces worden vele zorgvuldige af- en overwegingen gemaakt die uiteindelijk kunnen leiden tot wapeninzet. Enkele van deze afwegingen zijn al genoemd in de alinea over het oorlogsrecht (bijvoorbeeld de proportionaliteitsanalyse). Kijkend naar de werking van de Harpy blijkt dat zelfs de autonome uitvoering van cruciale functies door een systeem niet in strijd hoeft te zijn met het HOR. De kunst is namelijk om deze cruciale functies te plaatsen binnen de context van het targeting proces.

Het targeting proces is onderverdeeld in de fasen planning, uitvoering en evaluatie. De cruciale functies die de Harpy autonoom uitvoert, vinden plaats tijdens fase 2. De Harpy vliegt na lancering autonoom naar het patrouillegebied waarna het zonder verdere menselijke controle op zoek gaat naar vijandelijke radarsignalen en deze uitschakelt. Dit is onderdeel van de praktische uitvoering van de missie. Gedurende deze missie-uitvoering moeten de acties van de Harpy in overeenstemming zijn met het voorgeschreven oorlogsrecht. De Harpy is echter geen intelligent systeem met onderscheidend vermogen (het kan geen onderscheid maken tussen civiele en militaire objecten met uitzondering van radarsignalen) en heeft geen situational awareness of menselijk oordeelsvermogen (belangrijke factoren voor de uitvoering van de proportionaliteitsanalyse wanneer nevenschade wordt verwacht en de bepaling van militaire noodzaak). Hoewel hier zeker vraagtekens bij gezet kunnen worden, en misschien ook wel moeten worden, is de inzet van de Harpy niet (noodzakelijk) in strijd met het HOR.[57] Dat komt onder meer doordat het targeting proces ruimte geeft voor uitvoerige planning en controle waarbij diverse factoren van bijzonder belang zijn.

Controle door middel van programmering

Technologische ontwikkelingen maken het mogelijk om steeds meer taken aan programmering over te laten. In het geval van de Harpy zien we dit terug in de programmering van het systeem, m.a.w. het vullen van de interne bibliotheek waaruit de Harpy zijn vergelijkingsmateriaal of target parameters haalt. De inhoud van de interne bibliotheek bepaalt welk doelwit het systeem als vijandelijk moet beschouwen en vervolgens mag uitschakelen. Dat betekent dat, ondanks dat de Harpy een praktische doelselectie uitvoert gedurende de uitvoering van de missie, de specificatie van de parameters voor deze doelselectie al heeft plaatsgevonden, en wel door mensen. Huidige systemen kunnen met grote zekerheid vaststellen wat een vijandelijk radarsignaal is en zullen dit bijvoorbeeld niet verwarren met het signaal van een mobiele telefoon. De programmering van deze herkenningssoftware is in dit geval een manier om menselijke controle uit te oefenen in een vroeg stadium, zodat in een later stadium (gedurende de uitvoering) het systeem voorspelbaar is in zijn acties zodat, ondanks de autonome functies, de Harpy feitelijk onder menselijke controle opereert.

Geografische controle

Ook al kan de Harpy een vijandelijk radarsignaal onderscheiden van een signaal van een mobiele telefoon, dat betekent niet dat de Harpy volledig onderscheidend vermogen heeft zoals bedoeld in het HOR. Het is daarom van belang dat aanvullende voorzorgsmaatregelen worden getroffen die ervoor zorgen dat de Harpy burgers geen schade zal berokkenen die als onrechtvaardig wordt beschouwd. Dit kan door middel van geografische controle. Het beheersen van het geografische gebied waarbinnen een systeem opereert is bij stationaire systemen een stuk eenvoudiger dan bij mobiele systemen. De SGR-A1 Samsung robot, die de gedemilitariseerde zone tussen Noord en Zuid-Korea bewaakt, is een voorbeeld van een stationair systeem met autonome functies.[58] Dit systeem heeft een volautomatische modus waarbij de doelselectie en ook de uiteindelijke beslissing om geweld te gebruiken genomen kan worden zonder menselijke tussenkomst.[59] In het geval van de SGR-A1 robot is het gebied zorgvuldig afgebakend; het is een gedemilitariseerde zone, afgebakend door een serie van obstakels en barrières compleet met mijnvelden en prikkeldraad.[60] De zone is verboden voor mensen om te betreden.[61] Ook al kan het systeem geen onderscheid maken tussen een burger en een militair, deze geografische controle verkleint het risico op burgerslachtoffers significant.

Bij de Harpy, een mobiel wapensysteem, is deze geografische afbakening een stuk lastiger en vereist het een case-by-case benadering. Zo zal een commandant in een asymmetrische situatie geen Harpy mogen inzetten in een gebied waar zich burgerdoelen bevinden. Het risico dat een vijandelijk radarsignaal opzettelijk wordt uitgezonden vanaf een ziekenhuis of een school is dan te groot. De Harpy is ook geen geschikt systeem om in te zetten in stedelijk gebied. Het is de verantwoordelijkheid van de commandant om de juiste voorzorgsmaatregelen te nemen, hetgeen een vereiste binnen het HOR is. Daarnaast kan een commandant nog andere voorzorgsmaatregelen nemen zoals het inzetten van RPAs welke het gebied waarbinnen de Harpy opereert surveilleren. De operator en de commandant kunnen dan vanuit een controle- of operatiecentrum real-time meekijken met de RPA’s beelden en de Harpy uitschakelen voordat het zijn doel bereikt, mocht daartoe aanleiding zijn. Dit zijn beide manieren om menselijke controle uit te oefenen over een systeem welke grotendeels autonoom opereert.

Temporele controle

Een andere manier van menselijke controle over systemen met autonome functies is het beheersen van de tijdspanne waarbinnen het systeem operationeel is. Deze temporele factor is te verdelen in twee manieren van controle. De eerste methode om controle uit te oefenen over een autonoom functionerend systeem is het beheersen van de tijd tussen de planning van de missie (bijvoorbeeld het vaststellen van het target gebied) en de uitvoering, en daarmee het geweldgebruik. Des te kleiner het tijdsraam tussen de planning en uitvoering, des te meer er van de commandant verwacht mag worden te weten over de situatie in het desbetreffende gebied.[62] De tweede methode om controle uit te oefenen betreft de periode waarbinnen het autonoom functionerende systeem operationeel is. De Harpy heeft geen situational awareness en kan daarom geen inschatting maken van eventuele disproportionele nevenschade. Aangezien er maar weinig conflictgebieden zijn waar burgers of civiele objecten geen onderdeel van uitmaken, zal een operatie met een systeem zoals de Harpy altijd een (strikte) tijdslimiet moeten hebben.[63]

Voorspelbaarheid

Al deze factoren – programmering, geografische en temporele controle – bevatten elementen die invloed uitoefenen op de voorspelbaarheid van het systeem. Hoe meer menselijke controle over genoemde factoren, des te groter is de voorspelbaarheid, en vice versa. De vraag is, of een systeem dat als relatief voorspelbaar wordt beschouwd in een bepaalde omgeving, onvoorspelbaar is in een andere omgeving. Een systeem met autonome functies opererend onder water of in de ruimte zal heel anders handelen wanneer het wordt ingezet in stedelijk gebied. Daarnaast betekent voorspelbaarheid in handelen iets anders dan voorspelbaarheid in effecten. Een bepaald handelen kan voorspelbaar zijn, maar in de interactie met een bepaalde omgeving, met andere systemen en actoren kan de uitkomst of het effect onbekend zijn.[64] Dit kan enerzijds militair voordeel opleveren ten opzichte van de tegenpartij, anderzijds brengt deze onvoorspelbaarheid ook risico’s met zich mee. Ontwikkelingen op het gebied van kunstmatige intelligentie spelen hier een grote rol in. Zelflerende systemen bieden veel voordelen, maar deze systemen zijn ook een stuk lastiger te voorspellen en daarom moeilijker in toom te houden.[65] Om hier enigszins een balans in te vinden, zou het concept van Meaningful Human Control een beslissende rol kunnen spelen.

Conclusie

Autonome wapensystemen zijn steeds meer onderwerp van discussie. Onduidelijkheid over deze wapens en de angst die met deze ontwikkeling gepaard gaat, zorgt ervoor dat het debat vaak gevoerd wordt op grond van emotionele argumenten en semantiek. Ook het vormen van een alomvattende definitie van deze wapens, en daarmee specifiek het autonome karakter, blijkt een zeer complexe opgave die meer verwarring veroorzaakt dan wegneemt. Desondanks is inzage in een aantal concepten en begrippen onontbeerlijk om feiten en fabels te kunnen scheiden.

Een eerste inzicht is dat een systeem verschillende (acceptabele en cruciale) functies kan hebben die autonoom kunnen zijn en een AW niet gedurende een hele missie op een bepaald niveau van autonomie opereert. Tweede inzicht is dat doelbestrijding (targeting) een georganiseerd proces is waar deze functies en menselijke controle in verschillende fasen wordt uitgeoefend. Tot slot, autonome functies moeten altijd worden gezien in relatie tot het menselijk handelen (autonomie betekent niet dat een systeem de taken van de mens overneemt, het betekent dat de taken van de mens een andere vorm aannemen) en de context waarbinnen deze functies worden ingezet. Menselijke controle kan verschillende vormen aannemen dat in samenspel met de context als betekenisvol (meaningful) kan worden bestempeld of niet. Hierbij bieden in ieder geval vier factoren houvast: (1) controle door middel van programmering, (2) geografische controle, (3) temporele controle, en (4) de mate van voorspelbaarheid.

Het concept van MHC zou moeten garanderen dat aanvallen altijd in overeenstemming met het voorgeschreven HOR kunnen zijn.[66] Door het targeting proces als referentiekader te gebruiken worden bovendien militair-operationele elementen aan het concept toegevoegd. Ook al kunnen AWs ingezet worden conform het voorgeschreven HOR en binnen de vereisten van het targeting proces, de ethische vraag ‘ hoe ver de ontwikkeling van autonome technologie voor wapensystemen gaat’ , blijft relevant. Kortom, hoewel het concept van MHC nog niet alle vragen naar aanleiding van AWs kan beantwoorden, heeft het de potentie om het debat over AWs in de juiste richting te sturen. Het begin is er; het is nu aan de ingenieurs, juristen, ethici, beleidsmedewerkers, maar vooral ook de krijgsmacht en de maatschappij om te bepalen hoe de controle over steeds autonomere wapensystemen behouden zou moeten worden.

[1] M. Boot, War Made New: Weapons, Warriors and the Making of the Modern World (New York, Penguin Group, 2006).

[2] M.P. Roorda, ‘Niks mis met bewapenen Nederlandse Reapers’, in: Militaire Spectator 183 (2014) (7/8) 366-367. En: L. Kruizinga, ‘Frames in het debat over onbemande vliegtuigen (UAV’s)’, in: Militaire Spectator 183 (2014) (9) 376-390. Zie ook: P. Ducheine & F. Osinga, ‘(On)Duidelijkheid bij Drones’, in: Internationale Spectator 68 (2014) (9) 41-43.

* Merel Ekelhof vervulde stages bij Pax en CLSK/NLDA. Thans verricht zij promotieonderzoek op dit thema aan de Universiteit van Amsterdam, Faculteit Rechtsgeleerdheid, Sectie Militair Recht. De auteur dankt luitenant-kolonel Vincent Lengkeek EMSD en brigade-generaal prof. Paul Ducheine voor hun suggesties.

[3] Kruizinga, 381. MALE UAV staat voor: Medium Altitude Long Endurance Unmanned Aerial Vehicle.

[4] NGO: niet-gouvernementele organisatie.

[5] CCW: Convention on (certain) conventional weapons.

[6] Tweede Kamer der Staten Generaal, ‘Vaststelling van de begrotingsstaten van het Ministerie van Defensie (X) voor het jaar 2014’ (2013) 1.

[7] US Department of Defense, ‘Directive 3000.09’ (2012) 13, beschikbaar via: http://www.dtic.mil/whs/directives/corres/pdf/300009p.pdf

[8] Voor meer informatie over de Campagne ga naar: http://www.stopkillerrobots.org.

[9] In mei 2013 presenteerde VN Speciale Rapporteur voor buitenrechtelijke executies Christof Heyns zijn rapport waarin hij oproept tot een wereldwijd moratorium op het ontwikkelen, produceren, testen, (ver)kopen en gebruiken van ‘Lethal Autonomous Robotics’ (LARs) in de VN Mensenrechtenraad in Genève. Voor het volledige rapport zie: ‘Report of the Special Rapporteur on extrajudicial, summary or arbitrary executions, Christof Heyns’, UNGA Doc. A/HRC/23/47 (2013).

[10] In november 2013 adopteerde de Verdragspartijen van de CCW een mandaat om in mei 2014 een Meeting of Experts te organiseren. Van 13 tot 16 mei 2014 bespraken delegaties vanuit 87 landen de vragen die voortvloeien uit de ontwikkeling in technologieën op het gebied van ‘Lethal Autonomous Weapons Systems’ (LAWS) in Genève. Voor meer informatie zie: Chairperson of the Meeting of Experts, ‘Report of the 2014 informal Meeting of Experts on Lethal Autonomous Weapons Systems (LAWS)’ (2013).

[11] 1980 Convention on Certain Conventional Weapons, Protocol IV on Blinding Laser Weapons (13 Oktober 1995). Een ander voorbeeld van een preventief wapenverbod was het verbod op exploderende kogels vastgelegd in het Verdrag van Sint-Petersburg in 1868.

[12] J. Eijsvoogel en M. Kranenburg, ‘Ik worstel enorm met het gebruik van drones’, in: NRC Handelsblad (18/12) (2012).

[13] In januari 2013 vond de minister van Buitenlandse Zaken het hoog tijd om meer duidelijkheid te krijgen over de volkenrechtelijke aspecten van aanvallen met bewapende drones. De CAVV werd verzocht om te adviseren over de rechtmatigheid en voorwaarden voor het gebruik van drones. Zie Commissie van Advies inzake Volkenrechtelijke Vraagstukken, ‘Advies inzake Bewapende Drones’, (2013).

[14] Eijsvogel en Kranenburg.

[15] Commissie van Advies inzake Volkenrechtelijke Vraagstukken. In januari 2015 diende het ministerie van Buitenlandse Zaken en het ministerie van Defensie een adviesaanvraag in bij de AIV & CAVV over LAWS.

[16] Ministerie van Defensie, ‘Patriot luchtverdedigingssysteem’, beschikbaar via: http://www.defensie.nl/onderwerpen/materieel/inhoud/bewapening/patriot-luchtverdedigingssysteem

[17] Ibid.

[18] Zie bijvoorbeeld: N. Sharkey, ‘Automating Warfare: lessons learned from the drones’, in: JL Inf. & Sci. 21 (2011) 141.

[19] Ibid.

[20] United Kingdom Ministry of Defence, ‘Joint Doctrine Note 2/11: The UK Approach to Unmanned Aircraft Systems’ (2011) 2-3.

[21] Ibid.

[22] Sharkey. En: M.N. Schmitt en J.S. Thurnher, ‘“Out of the Loop”: Autonomous Weapon Systems and LOAC’ in: Harvard National Security Journal 4 (2013) 268. Zie ook: P. Hew et al. ‘Situation awareness for supervisory control: two fractricide cases revisited’ in: International Command Control Research and Technology Symposium (2010). En: Human Rights Watch and International Human Rights Clinic, ‘Losing Humanity: The Case Against Killer Robots’ (2012) 2.

[23] De Amerikaanse krijgsmacht maakt veelvuldig gebruik van deze niveaus van autonomie. De Amerikaanse landmacht maakt bijvoorbeeld gebruik van tien niveaus, de Amerikaanse marine onderscheidt drie niveaus en de Amerikaanse luchtmacht beschrijft vier niveaus van autonomie op het gebied van wapencontrole. Zie bijvoorbeeld: R. Johnson ea. ‘Adaptive Levels of Autonomy (ALOA) for UAV Supervisory Control’ (2005) 20-21, beschikbaar via: www.dtic.mil/cgi-bin/GetTRDoc?AD=ADA437269. En: National Research Council, Autonomous Vehicles in Support of Naval Operations. (Washington DC, The National Academies Press, 2005) 45-6. En ook: United Nations Institute for Disarmament Research, ‘Framing Discussions on the Weaponization of Increasingly Autonomous Technologies’ in: UNIDIR Resources 1 (2014) 3. En: United States Air Force ‘Unmanned Aircraft Systems Flight Plan 2009-2047’ (2009) 39. En: N. Sharkey, ‘Cassandra or False Prophet of Doom: AI Robots and War’ in: IEEE Intelligent Systems 2008, 39.

[24] United Nations Institute for Disarmament Research, 3.

[25] Defense Science Board, ‘Task Force Report: The Role of Autonomy in DoD Systems’, (2012) 4. David Woods, hoogleraar bij de Universiteit van Ohio in het departement Integrated Systems Engineering, bevestigt deze vaststelling in zijn artikel over de zeven dodelijk mythes over autonome systemen. Woods e.a. stellen dat het begrip autonomie niet ‘eendimensioneel’ is (een enkel ding waarvan iedereen begrijpt wat het is) en dat een schaal om autonomie op te meten ineffectief is. J.M. Bradshaw, R Hoffman, M. Johnson, en D. Woods, ‘The Seven Deadly Myths of ‘Autonomous Systems’’ in: IEEE Intelligent Systems (2013) 2.

[26] Bij de RQ-4 Global Hawk hoeft een operator enkel een knop in te drukken om op te stijgen en te landen en de RPA krijgt routeaanwijzingen via GPS en muisklikken op een navigatiekaart. Ook de Amerikaanse Sky Warrior en de Shadow gebruiken een automatisch landingssysteem. Niet alle RPA’s maken gebruik van deze software. Eén van de redenen hiervoor lijkt ook te liggen in het gebrek aan enthousiasme onder de vliegers van de Amerikaanse Luchtmacht. Zie: S. Gallagher, ‘Military under the gun on unmanned aerial system mishaps’ in: Defense Systems (2009). En: P.W. Singer, ‘A Revolution Once More: Unmanned Systems and the Middle East’, in: Future Horizon (2009) 83-87.

[27] De X-47B is dan wel een Amerikaanse variant, de Verenigde Staten zijn niet het enige land dat experimenteert met deze geavanceerde technologieën. Een vergelijkbaar systeem wordt ontwikkeld in het Verenigd Koninkrijk genaamd Taranis. In Europa is de nEUROn het meest vergelijkbare systeem.

[28] Multinational Capability Development Campaign, ‘Proceedings Report Autonomous Systems Focus Area’ (2014) 6.

[29] BigDog is een robotisch muildier ontwikkelt door Boston Dynamics en DARPA. Het muildier heeft vier benen en is speciaal ontwikkeld om ruw terrein te begaan. DARPA experimenteerde in 2008 met autonome functies voor de BigDog, zoals autonome navigatie. Vergelijkbare ontwikkelingen zijn de humanoïde robot ‘Atlas’ en de snelle vierpotige ‘WildCat’. M. Raibert e.a., ‘BigDog, the Rough-Terrain Quaduped Robot’ (2008) beschikbaar via: http://www.bostondynamics.com/img/BigDog_IFAC_Apr-8-2008.pdf.

[30] United Nations Institute for Disarmament Research, 3. Paul Scharre en Michael Horowitz voegen hieraan toe dat ontwijkende manoeuvres en niet-dodelijke tegenmaatregelen zoals ‘flares’ en ‘chaff’ ook weinig bezwaren oproepen. P. Scharre en M.C. Horowitz, ‘An Introduction to Autonomy in Weapon Systems’, in: Center for New American Security Project on Ethical Autonomy Working Paper (2015) 18.

[31] Internationale Comité van het Rode Kruis, ‘Convention on Certain Conventional Weapons (CCW) Meeting of Experts on Lethal Autonomous Weapons Systems (LAWS, 13-16 May 2014, Geneva – Statement of the International Committee of the Red Cross (ICRC)’ (2014) beschikbaar via: https://www.icrc.org/eng/resources/documents/statement/2014/05-13-autonomous-weapons-statement.htm

[32] Ook dient er gekeken te worden naar de human-system relatie. Zo een samenwerking heeft naast technische effecten ook psychologische en militair-operationele effecten. Zie bijvoorbeeld: H. Knight, ‘How Humans Respond to Robots: Building Public Policy through Good Design’, in: Brookings Center for Technology Innovation (2014). In de strekking van dit artikel laat ik deze effecten buiten beschouwing.

[33] G. Di Marzio, ‘The Targeting Process… This Unknown Process (Part I)’, in: NRCD-ITA Magazine 13 (2009) 11.

[34] Zie P. Ducheine, M. Schmitt, F. Osinga, Targeting: The Challenges of Modern Warfare, Springer/TMC Asser Press 2015 (forthcoming).

[35] NATO, ‘Allied Joint Doctrine for Joint Targeting – AJP-3.9’ (2008) 10.

[36] Zie bijvoorbeeld: Ministerie van Defensie ‘Joint Doctrine Publicatie 5 - Commandovoering' (2012) beschikbaar via: http://www.defensie.nl/onderwerpen/doctrine/documenten/publicaties/2012/03/16/joint-doctrine-publicatie-5-commandovoering-nl . En: US Department of the Army, ‘The Targeting Process’ (2010) beschikbaar via: http://armypubs.army.mil/doctrine/DR_pubs/dr_a/pdf/fm3_60.pdf. En ook: NATO, ‘Allied Joint Doctrine for Joint Targeting – AJP-3.9’ (2008).

[37] Denk hier bijvoorbeeld aan software dat bewegingspatronen analyseert.

[38] A. Saenz, ‘US Military Drowning in Drone Data’, in: Singularity Hub (22/1) (2010). En: C. Drew, ‘Military Is Awash in Data From Drones’ in: New York Times (10/1) (2010).

[39] Op wetenschappelijk en civiel vlak is de ontwikkeling van autonome software al redelijk vergevorderd. Denk bijvoorbeeld aan de Google Self-Driving Car. De ontwikkeling van autonome software voor militaire doeleinden is nog lang niet op hetzelfde niveau. Zie: Darpa drone contest, beschikbaar via: http://www.wired.com/2012/06/darpa-uavforge. En: Weimar e.a., Miniature UAVs: an Overview (Den Haag, TNO, 2014) 39.

[40] Drew.

[41] Reden hiervoor is niet alleen de hoeveelheid sensors, informatie en data (data drowning) maar ook de bandbreedte beperkingen, de complexiteit van de informatie is nauwelijks meer te bevatten en te interpreteren, en de snelheid die zulke software mogelijk maakt kan militair voordeel opleveren. Dit zijn onderwerpen waar TNO onderzoek naar verricht. Zie bijvoorbeeld: J. Dijk e.a. ‘Image processing in aerial surveillance and reconnaissance: from pixels to understanding’, in: Proceedings of SPIE 8897, 88970A (2013).

[42] Ook kan zulke technologie de mens helpen met het identificeren van vijandelijke gedragspatronen in grote hoeveelheden data. Dit soort ontwikkelingen op het gebied van autonome informatieverwerking zien we bijvoorbeeld in producten als ‘HP IDOL’. Dit is een systeem dat autonoom relaties en patronen kan ontdekken in grote hoeveelheden ongestructureerde data (audio, video, afbeeldingen, webinhoud). Voor meer informatie over de HP IDOL ga naar: www.autonomy.com/products/idol.

[43] Als de sensor een vijandelijk radarsysteem detecteert, zal hij zich daarop richten met de hoog-explosieve lading en zal hij zich op dat systeem storten. Het systeem kan een aanval afbreken als de radar wordt uitgeschakeld maar het heeft geen herstel mogelijkheid. Israel Aerospace Industries, ‘Harpy – Lethal Anti-Radar Attack UAV’, beschikbaar via: http://www.iai.co.il/Sip_Storage//FILES/4/34884.pdf En: Defense Update, ‘Israel Unveils Loitering Anti-Missile Drone’, beschikbaar via: http://defense-update.com/products/h/harop.html

[44] Voor een volledige beschrijving van de werking van dit systeem zie: Defense Update, ‘Harpy Air Defense Suppression System’, beschikbaar via: http://defense-update.com/directory/harpy.htm

[45] Het enige bezwaar dat ooit is gemaakt met betrekking tot de Harpy was politiek gemotiveerd en had te maken met de relatie tussen China en de VS. China stuurde in 2004 haar Harpies terug naar Israel voor een upgrade maar de VS gebood Israel de Harpies te confisqueren en contracten met China nietig te verklaren.

[46] E.H. Pouw. en P.A.L. Ducheine, ISAF Operaties in Afghanistan (Nijmegen, Wolf Legal Publishers, 2010) 110.

[47] M.N. Schmitt, ‘Fault Lines in the Law of Attack’, in: Testing the Boundaries of International Humanitarian Law (2006), 293.

[48] C. Grut, ‘The Challenge of Autonomous Lethal Robotics to Internatinoal Humanitarian Law’, in: Journal of Conflict and Security Law 18 (2013) (1), 7.

[49] International Criminal Tribunal for the Former Yugoslavia, ‘Prosecutor v. Stanislav Galic - Case No. IT-98-29-T’ (2003).

[50] International Committee of the Red Cross, par. 2208.

[51] Zie bijvoorbeeld: A. Burt, ‘Letter of the UK Foreign & Commonwealth Office to Amnesty International on UK’s current policy regarding fully autonomous weapons – MIN/50240/2013’, (2013), beschikbaar via: http://www.article36.org/wp-content/uploads/2013/06/50240-Signed-Final.pdf

[52] Artikel 36 van het Aanvullend Protocol van de Conventies van Genève stelt dat Verdragspartijen bij de studie, ontwikkeling, aanschaf of invoering van een nieuw wapen, een nieuw middel of een nieuwe methode van oorlogvoering de verplichting heeft vaste te stellen of het gebruik daarvan, in bepaalde of in alle omstandigheden, door dit Protocol of door enige andere regel van het toepasselijk internationaal recht is verboden. Dit artikel is van toepassing op de ontwikkeling en inzet van autonome wapensystemen wat betekent dat het gebruik van AWs niet in strijd mag zijn met bovengenoemde bestaande beginselen. Zie ook: Swiss Confederation, ‘Réunion d’Experts de la Convention sur Certaines Armes Classiques, General exchange of views’ (2014), 5. De Zwitserse vertegenwoordiging stelt dat het internationaal recht in haar volledigheid (VN Handvest, mensenrechten en HOR) gerespecteerd dient te worden bij de ontwikkeling en inzet van LAWS.

[53] Zie bijvoorbeeld: Statement by Pakistan in the Interactive Dialogue with the Special Rapporteur on Extrajujdicial, Summary or Arbitrary Executions 23rd Session of the Human Rights Council, te beluisteren via: http://webtv.un.org/watch/clustered-id-on-executions-and-idps-9th-meeting-23rd-regular-session-of-human-rights-council/2419860354001. En: C. Heyns, ‘Report of the Special Rapporteur on Extrajudicial, Summary or Arbitrary Executions, Christof Heyns A/HRC/23/47’, beschikbaar via: http://www.ohchr.org/Documents/HRBodies/HRCouncil/RegularSession/Session23/A-HRC-23-47_en.pdf. Zie ook: Campaign to Stop Killer Robots, ‘Call to Action’, beschikbaar via: http://www.stopkillerrobots.org/call-to-action/

[54] Chairperson of the Meeting of Experts, ‘Report of the 2014 informal Meeting of Experts on Lethal Autonomous Weapons Systems (LAWS)’ (2013) 3.

[55] Statement van de ICRC tijdens de CCW Meeting of Experts in mei 2014. Zie bijvoorbeeld ook: ICRC, Convention on Certain Conventional Weapons Meeting of Experts on LAWS, Statement of the ICRC by Kathleen Lawand (2014) beschikbaar via: http://www.unog.ch/80256EDD006B8954/(httpAssets)/C99C06D328117A11C1257CD7005D8753/$file/ICRC_MX_LAWS_2014.pdf

[56] The Future of Life Institute, Research Priorities for Robust and Beneficial Intelligence: an Open Letter (2015), beschikbaar via: http://futureoflife.org/static/data/documents/research_priorities.pdf

[57] Elk wapensysteem kan ingezet worden in strijd met het internationaal humanitair recht, maar dat betekent niet dat het systeem zelf in strijd is met het IHR, enkel dat deze strijdig gebruikt wordt.

[58] De SGR-A1 is uitgerust met een alarmsysteem, rubberen kogels en een machinegeweer. Het kan een indringer binnen de grenzen van het gebied detecteren en kan een mens onderscheiden van een dier of andere objecten. Wanneer het een indringer detecteert kan het systeem deze persoon waarschuwen en de persoon kan vervolgens een aanval voorkomen door middel van het geven van de juiste code of door zijn of haar armen omhoog te doen en daarmee overgave ter demonstreren.

[59] Voor meer informatie over de werking van dit systeem zie: Global Security, ‘Samsung Techwin SGR-A1 Sentry Guard Robot’, beschikbaar via: http://www.globalsecurity.org/military/world/rok/sgr-a1.htm

[60] Ibid.

[61] Ibid.

[62] Article 36, ‘Structuring Debate on Autonomous Weapon Systems’ (2013) 2, beschikbaar via: http://www.article36.org/wp-content/uploads/2013/11/Autonomous-weapons-memo-for-CCW.pdf

[63] M. Schmitt en J. Thurnher, ‘’Out of the Loop’: Autonomous Weapon Systems and the Law of Armed Conflict.’ In: Harvard National Security Journal 4 (2014) 250.

[64] United Nations Institute for Disarmament Research, ‘Considering how Meaningful Human Control might move the discussion forward’ in: UNIDIR Resources 2 (2014).

[65] The Future of Life Institute, 7.

[66] Uitzonderingen daargelaten. Een mens kan altijd fouten maken en een systeem kan falen.